C’est un débat sans fin en France : faut-il forcément des centrales nucléaires pour décarboner notre système électrique? Peut-on couvrir notre consommation principalement avec de l’éolien et du solaire ?

Jean-Marc Jancovici est connu pour ses positions pronucléaires, et propose un calcul d’ordre de grandeur qui semble invalider la généralisation des renouvelables. Problème : un certain nombre d’études détaillent des “mix énergétiques” bon marché à 100% de renouvelables, en particulier celle du CIRED qui vient de sortir pour la France (notée par la suite Shirizadeh et al.).

C’est l’occasion de revenir sur le débat en analysant cette étude en parallèle de l’article de Jancovici.

Le cadre du débat

C’est la règle non négociable : le réseau électrique doit toujours être équilibré, chaque instant la production égale à la consommation. Notons que la question se pose à l’échelle européenne, les réseaux étant interconnectés. Aujourd’hui le réseau électrique et les moyens de productions sont dimensionnés pour à la fois couvrir le pic de charge, quand la consommation est maximale, et être réduits à la baisse si nécessaire. En France le pic de charge est généralement en début de soirée l’hiver, autour de 100 GW : on a donc construit assez de centrales pour le couvrir. On dispose de plusieurs grands leviers pour équilibrer production et consommation sans construire plus de centrales :

- stocker l’énergie quand on en a trop. Problème : aujourd’hui le stockage est cher (batteries) ou difficile à développer (barrages)

- lisser la consommation, par exemple via les tarifs heures creuses / pleines, ou la limiter pendant les pics

- arrêter la production quand on n’en a pas besoin, ce qui est plus ou moins facile et rentable selon le type de centrale

Aujourd’hui c’est plutôt simple d’équilibrer : il suffit d’arrêter ou démarrer des centrales en fonction de la consommation. Cela devient beaucoup plus complexe quand la majorité de la production dépend du vent et du soleil, et c’est donc l’enjeu principal du choix des moyens de production électrique décarbonés pour l’avenir. La grande question est celle du coût plutôt que de la faisabilité, qui ne fait pas vraiment débat (on peut aller très loin si l’on met les moyens, par exemple en achetant beaucoup de stockage pour couvrir l’intermittence). Le grand intérêt de cette nouvelle étude est d’explorer les incertitudes autour de ce coût en fonction de ses hypothèses, en plus de valider l’équilibre du système proposé. Si par exemple le stockage se révèle plus cher que ce qu’on estimait, on sait ici combien cela coûte pour garder le système équilibré.

Notons d’emblée que Jancovici et Shirizadeh et al. ne répondent pas exactement à la même question. Le premier se place dans les conditions actuelles (article de 2017 et chiffres des dernières années) alors que le second vise un système électrique en 2050 (en cohérence avec l’objectif d’atteindre la neutralité carbone à cette date). L’avantage de partir de chiffres actuels fiables est aussi l’inconvénient de ne pas prendre en compte les évolutions futures, et réciproquement !

Nous allons nous pencher sur leurs méthodes de calcul respectives.

Méthodologie Jancovici

Jean-Marc Jancovici utilise des chiffres récents pour la consommation, les rendements, les coûts et les technologies. Les stations de pompage-turbinages (imaginez deux barrages l’un en dessous de l’autre) sont le mode de stockage privilégié, en supposant qu’on pourra noyer quelques vallées et déplacer leurs habitants. Les chiffres sont la plupart bien sourcés, mais pas toujours avec la référence exacte.

Son calcul suit les étapes suivantes :

- Remplacer la production globale annuelle du nucléaire avec du solaire ou de l’éolien. Il en déduit la capacité nécessaire en divisant par les facteurs de charge actuels (rapport entre la production réelle d’une centrale et son maximum théorique).

- Il y ajoute une estimation des coûts de réseau pour raccorder ces capacités et distribuer l’électricité produite, avec le même ratio que l’Allemagne aujourd’hui (1€ de réseau à construire pour 1€ de centrale éolienne ou solaire)

- Il estime la puissance de stockage nécessaire comme la différence entre la production maximale et le minimum de consommation (plus importante que l’inverse). Pour la capacité de stockage il considère la variabilité des productions et estime la quantité à prévoir de 50% de la production annuelle pour l’éolien et 80% pour le solaire (la production totale étant égale à celle du nucléaire, il faut la répartir sur toute l’année).

- Il multiplie par coûts et durée de vie pour avoir le coût global par an du système. Voici le tableau de résultats :

Le grand intérêt du modèle est sa simplicité : il est entièrement compréhensible et vérifiable par n’importe qui dispose de quelques bases sur le sujet, par exemple tout ingénieur généraliste.

Ce calcul souffre pourtant de limites énormes en voulant simplifier la complexité du système électrique. En particulier l’estimation de la capacité de stockage n’a aucun rapport avec le fonctionnement réel du réseau, oublie les autres énergies (28% de la production française), et considère qu’il faut stocker toute production excessive d’électricité tout en la répartissant sur une année entière (on peut très bien “débrancher” une éolienne du réseau, ce qu’on appelle l’écrêtage, on ne le fait juste pas aujourd’hui car le prix de rachat est garanti). Elle semble donc grossièrement surestimée.

Jean-Marc Jancovici teste ensuite l’effet de variations importantes de coûts du renouvelable ou du nucléaire et conclut que sa conclusion tient toujours. Je ne suis pas du tout convaincu par cette astuce habituelle de consultant : tester la sensibilité aux paramètres d’un calcul d’ordre de grandeur très grossier ne rend pas le résultat rigoureux.

L’auteur a le mérite de se pencher sur un sujet technique peu populaire mais important : la stabilité en fréquence. Elle est aujourd’hui assurée principalement par le nucléaire et les barrages au fil de l’eau, qui sont connectés au réseau 100% du temps et gardent pour ce besoin une partie de leur puissance en réserve. Dans un monde à majorité éolien et solaire cela devient beaucoup plus complexe, et nécessite par exemple des batteries (qui sont de plus en plus utilisées pour la tenue en fréquence et autres services système).

Méthodologie Shirizadeh et al.

Dès le début de leur présentation les auteurs prennent soin de se distinguer d’une étude sur un mix 100% renouvelable qui avait alimenté les débats, celle de l’ADEME. Ils semblent d’ailleurs éviter par leurs hypothèses les critiques que Jean-Marc Jancovici ou Sylvestre Huet avaient exprimées sur cette étude, notamment un exportateur miraculeux qui vient répondre aux pics de consommation, et des hypothèses de lissage de la consommation très optimistes. Celle-ci est aussi revue par les pairs, et le modèle tout comme les données sont publics.

Shirizadeh et al. détaillent précisément leurs hypothèses et leurs sources, qui sont tous des études publiées ou des rapports gouvernementaux. Leur source pour la consommation est le scénario de l’ADEME, qui prévoit une stabilité de la consommation totale. Pour la technologie, les coûts et les rendements leur source principale est le scénario 2050 de la commission européenne. Enfin ils utilisent 18 ans de données météorologiques (2000–2017) pour calculer la variabilité de la production au niveau départemental.

L’étude, les résultats et les sources du modèle sont disponibles en ligne. Voici leur raisonnement :

- Ils construisent un modèle de mix électrique qui équilibre l’offre et la demande sur les 18 ans mesurés (calculés au pas horaire). Notons qu’ils se permettent d’écrêter la production quand elle dépasse la consommation, contrairement à Jancovici, pour un total de 11% de la production sur l’année.

- Ils calculent les coûts à partir des projections et adaptent le mix pour le minimiser (notons qu’ils partent d’un coût brut du production sans stockage et réseau, ajoutés à côté, et donc ne tombent pas dans l’erreur fréquente de le considérer comme un coût complet).

- Ils testent la sensibilité à l’année météo parmi les 18 années mesurées et concluent qu’il faut bien prendre en compte la diversité des situations, la “pire année” pour les renouvelables est celle qui dimensionne principalement le système

- Il testent la sensibilité au coût des technologies sur l’année 2006, qui a été la pire pour les renouvelables. Celle-ci s’avère faible : autour de +-5% sur le coût global pour des variations de coûts entre +-25% et +-50% sur les technologies (intervalles qui correspondent bien aux différences entre coût actuel et coût projeté). Il s’avère que le surcoût d’une technologie peut être en partie compensé en installant plus des autres. Si vous trouvez que les coûts estimés sont trop optimistes, vous pouvez jouer avec sur la page dédiée pour voir comment cela influe sur le mix énergétique optimal et le coût global du système.

Voici leurs conclusions pendant la présentation :

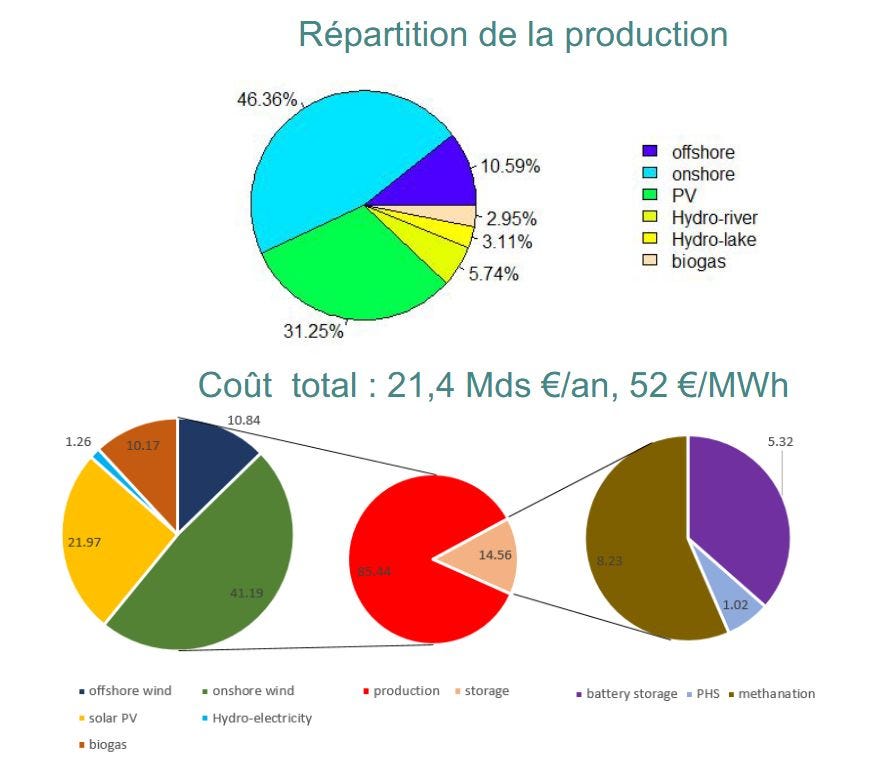

Et la répartition de la production et des coûts obtenue :

La méthodologie est clairement beaucoup plus rigoureuse que celle de Jancovici, se rapproche du fonctionnement réel des réseaux, et permet de prendre en compte finement la complexité du système énergétique. Pour calculer le besoin de stockage il n’y a pas d’autre moyen que simuler les historiques de production et de consommation, les règles de trois ne nous diront pas grand-chose. Le pas horaire est un bon niveau pour un scénario à 30 ans (aujourd’hui au jour le jour la prévision d’équilibrage est faite à un pas de 30 minutes).

J‘ai analysé l’étude sans rentrer dans le détail du code du modèle, n’ayant ni le temps ni l’expertise, mais le diable peut se cacher dans les détails. Ce n’est pas rare que des erreurs de calcul soient trouvés des années plus tard dans les publications qui utilisent des modèles numériques complexes, personne ne les revoit jamais au niveau de détail qui permettrait de vraiment les valider. Même si l’étude a été revue par des pairs et affiche des résultats cohérents avec la littérature, il faudra attendre les analyses d’experts du sujet pour être sûr de la correction du résultat.

En fait, même après analyse il est n’est pas toujours facile d’y voir clair. Par exemple une étude de 2017 présente un certain nombre de limites à la possibilité du 100% renouvelable, mais elle a été lourdement critiquée dans une autre publication. J’ai pu croiser des experts qui jurent par l’une ou par l’autre : lesquels croire ? J’atteins les limites de mes compétences d’ingénieur Supélec qui a suivi le sujet avec attention sans en être non plus spécialiste.

Parmi les marques de fiabilité on peut noter que l’étude a été présentée aux professionnels du secteur en France, dans plusieurs conférences, et est publiée dans la revue internationale la plus prestigieuse du domaine.

Revenons sur les hypothèses de Shirizadeh et al.

C’est un intérêt des publications scientifiques, les auteurs présentent d’eux-mêmes les limites principales qu’ils identifient dans leurs travaux :

On peut en ajouter quelques autres.

L’intervalle de sensibilité semble bien dosé pour les technologies existantes, mais la méthanation est encore expérimentale, jamais déployée à grande échelle, et la source du coût estimé un rapport de début 2017 d’un cabinet de conseil. Cela semble la principale incertitude technologique du modèle.

Les prix sont estimés dans le contexte actuel, c’est-à-dire un monde principalement fossile. Que se passe-t-il lorsqu’on doit produire des éoliennes dans un monde alimenté par des éoliennes ? La question est posée lors du wébinaire, mais l’étude mentionnée par les auteurs prévoit un passage de 12 à 6 du taux de retour énergétique. C‘est beaucoup !

Ne sont pas abordés les rendements décroissants de l’éolien, les meilleurs emplacements étant occupés en premier (ce qui peut aussi expliquer les facteurs de charges supérieurs aux Etats-Unis évoqués lors des questions). Est-ce trop optimiste d’estimer des gains de facteur de charge autour de 30% sur 30 ans ? Je ne sais pas, mais cet ordre de grandeur est bien couvert par l’étude de sensibilité.

Les coûts semblent calculés sur la base des projections pour 2050, alors qu’atteindre cette production nécessitera des dizaines d’années d’investissements progressifs, sur des technologies moins avancées et donc moins efficaces. La transition coutera donc probablement nettement plus cher.

La simulation n’inclut pas la question des services système comme la stabilité en fréquence, qui seront plus sollicités dans un système majoritairement renouvelable (les auteurs gardent la proportion actuelle de réserves par source d’énergie). Se pose plus généralement une question du coût de la complexité dans un monde où la production est répartie entre des milliers de centrales, même si les centrales à biogaz permettent de garder une bonne réactivité. Le système résultant est probablement très loin du “low-tech”.

Les auteurs n’ont pas estimé la sensibilité à la consommation, pour laquelle ils reprennent le scénario de l’ADEME. Ce scénario prévoit une légère baisse de la consommation alors qu’on doit en même temps électrifier la plupart des usages de combustibles fossiles, et repose donc sur des choix plus politiques que purement techniques (isolation, efficacité du transport, de l’industrie, sobriété …). Il aboutit aussi à un profil de consommation un peu plus lisse que celui actuel, ce qui doit changer nettement le besoin de stockage (c’est le pic de charge qui dimensionne le système). Notons que l’ADEME est en cours de revue de ces scénarios pour les affiner.

Enfin se posent plusieurs questions systémiques plus larges, qui sont rapidement abordées lors des questions et que les auteurs pensent explorer plus en détail à l’avenir :

- Quel espace utilisé par les éoliennes, le solaire et la biomasse ? Après calculs, le scénario prévoit de multiplier par 5 la puissance installée d’éoliennes terrestres, par 12 de photovoltaïque. Pour le biogaz (qui est produit soit directement soit par méthanation) la puissance installée est de deux fois la capacité actuelle de centrales à gaz, et la production de 3% du total contre 7% pour le gaz aujourd’hui. Si ce scénario minimise le coût, les émissions et le nucléaire, minimise-t-il vraiment l’impact environnemental ?

- Pourra-t-on généraliser ce système dans un monde aux ressources limitées ? Si les terres rares ne devraient pas être un problème la question se pose pour d’autres ressources et je n’ai pas été convaincu par la réponse des auteurs : l’enjeu est global plutôt que local, à l’échelle française on peut tout faire si on oublie le reste du monde.

Notons que certains coûts sont politiques avant d’être financiers, notamment l’installation d’éoliennes ou de nouveaux barrages.

A quel point ces limites remettent-elles en cause l’étude ? Je ne pense pas vraiment mais ces questions méritent des travaux complémentaires. De toute façon tout scénario pour 2050 est forcément très prospectif. Même si les auteurs se sont appliqués à bien expliciter les incertitudes on peut légitimement s’interroger sur le point auquel ce genre de projections doit guider les choix de société aujourd’hui.

Conclusion

Shirizadeh et al. sont nettement plus rigoureux sur le point crucial de l’équilibrage du réseau, mais on fait face à un paradoxe courant en modélisation : le modèle simple est moins puissant mais plus facilement compréhensible, le modèle complexe semble plus proche de la réalité mais son résultat repose sur plus d’hypothèses.

Les deux articles ne répondent pas exactement à la même question. Leurs réponses ne sont pas non plus incompatibles :

- Avoir un système 100% renouvelable semble coûter très cher aujourd’hui (on le constate en Allemagne qui a pris cette voie, avec un résultat climatique médiocre)

- Il sera possible d’avoir un mix 100% renouvelable abordable en 2050, si la consommation est contenue, si les progrès technologiques importants qu’on estime possibles aujourd’hui se réalisent (en particulier sur le biogaz et la méthanation) et plus globalement si toutes les limites de cet exercice ne le transforment pas trop en pratique.

Comme souvent, les désaccords entre “gens sérieux” portent principalement sur des hypothèses concernant le futur, pour lequel ils ne disposent pas de boule de cristal (contrairement à Marcel du café du commerce). Là où je trouve Jancovici critiquable, c’est qu’il semble donner trop de portée à son résultat, qui n’est qu’un ordre de grandeur très discutable et ne portant que sur le présent. Quant à l’étude du CIRED, il faut aussi bien comprendre sa portée : ce n’est pas une prévision, c’est un exercice construit sur des hypothèses qui par nature ne pourront pas être indiscutables.

Le faible coût du stockage est très intéressant, cela signifie qu’il n’est pas indispensable de baisser la consommation pour équilibrer le système (cela pourrait l’être pour d’autres raisons). Revenons à “l’affaire Dreyfus” franco-française de l’énergie, le nucléaire. Je tire aussi une autre conclusion de ce coût du stockage : si l’intermittence est compensée facilement alors le nucléaire est beaucoup moins économiquement incompatible avec le renouvelable que ce qu’on entend souvent. Shirizadeh et al. n’incluent pas de nucléaire dans leur modèle, mais arrivent à un coût proche du parc français actuel. Enfin, ce n’est pas dans l’étude, mais si le nucléaire pose moins de questions systémiques il souffre aussi de son lot d’incertitudes comme sur les générations futures de réacteurs. Encore d’excellentes raisons de prendre du recul face à l’envahissant débat technique “nucléaire contre renouvelables” ! Dans ce monde fatalement rempli d’incertitudes le jugement de Salomon de 50% de nucléaire en France ne semble pas si mauvais, et évite une sortie précipitée du nucléaire tout en expérimentant la montée en charge des renouvelables.

Cette perspective pose par contre la question très politique du pilotage économique, souvent discutée par Jancovici et à mon avis beaucoup plus intéressante pour le citoyen. Aujourd’hui les directives européennes ont métamorphosé le marché de l’électricité, qui est devenu un marché libre piloté par les coûts marginaux des différents producteurs et un prix instantané qui fluctue violemment. On ne voit pas bien comment cela pourrait fonctionner quand la grande majorité des moyens est à coût marginal nul, ce qui s’applique aussi au nucléaire (qui souffre en plus de cycles d’investissements très longs). On ne voit pas non plus comment ce marché pourrait nous y amener sans être dénaturé par des politiques inefficaces comme les garanties de prix (qui empêchent l’écrêtage et coûtent très cher). Pas de chance, ce sont les deux grandes voies technologiques pour décarboner l’électricité (ou, dans le cas de la France, y rester). Comment y arriver m’inquiète beaucoup plus que les nuances entre les deux.

Merci à l’auteur de l’étude Behrang Shirizadeh, à Rodolphe Meyer (Le Réveilleur) et à Bon Pote pour leurs relectures !

Written by

Science et politique d’un monde à réimaginer